微软紧随英伟达发布芯片,老黄还不慌吗?微软与英伟达芯片发布,老黄有何反应?

集团CEO纳德拉带来了长达一个小时的揭幕演讲,介绍微软在ESG、新一代空芯光纤、Azure Boost数据中心等项目的新动态。而整场演讲的重头戏,非AI莫属——尤其是首款自研AI芯片Azure Maia 100的亮相,成为场内场外无数聚光灯下的焦点。

微软重视AI人所共知,发力自研芯片也不是什么秘密。Maia 100的亮相,则是微软的第一张阶段性答卷,向外界表明自己的野心与实力。

有趣的是,英伟达CEO黄仁勋也来到现场,为Azure和英伟达合作的AI foundry service站台。纳德拉当着黄仁勋的面发布自研AI芯片,难免让人浮想联翩。

英伟达对高算力芯片的垄断,早已成为硅谷众大厂的心病。它们一方面离不开英伟达,另一方面又不想永远被英伟达掣肘。当自研芯片成为潮流,微软、Meta、谷歌、亚马逊先后亮出压箱底的宝贝,谁能真正挣脱枷锁?

(图片来自Pixabay)

微软首款AI芯片来袭,Maia 100成色几何?

首款芯片的命名从此前盛传的Athena改成Maia,灵感大概是参考了NGC 2336星系。Maia可以译为“明亮的蓝色恒星”,根据NASA的观测,NGC 2336星系近似螺旋形态,直径约20万光年,也以旋臂中的蓝色恒星闻名。以此命名自己的首颗AI芯片,微软或许是想以深邃的太空借喻充满想象力的AI世界,以及对算力的高追求。

Maia 100的亮相也不算突然,早在10月初就有媒体剧透微软将在开发者大会上发布首款自研AI芯片,并将向Azure云客户供应。不过微软对自研芯片计划的保密工作做得很好,直到正式发布后,外界才能真正了解其设计、算力和应用场景等详细情况。

根据纳德拉的介绍,Maia 100是一款AI加速芯片,基于Arm架构设计,主要用于云端训练、推理以及Azure的高负载云端运算。不过纳德拉否认了将向云计算客户供货的传闻,这款自研芯片将优先满足微软自身的需求,并在合适的时机向合作伙伴和客户开放。

Azure芯片部门负责人、微软副总裁拉尼·博卡尔则补充道,Maia 100已经在Bing和office的人工智能套件上测试。合作伙伴openAI也开始使用这款芯片进行测试部分产品和功能,比如GPT 3.5 Turbo。

(图片来自Azure官网)

至于测试的效果如何,微软暂时还没有给出具体报告。但纳德拉和博卡尔强调Maia 100可以加快数据处理速度,尤其是在语音和图像识别方面。

提速的关键,自然是算力。为了提升算力,微软也是下了血本:采用台积电的5nm制程工艺,晶体管数量达到1050亿个。和今年4月被曝光的信息相比,Maia的制程工艺、设计架构都没有太多出入,性能表现或许还需在应用数据来检验。

不过横向对比的话,Maia 100和英伟达、AMD等大厂的产品在参数上还有很大差距。AMD在今年发布的专用于AI加速的MI 300X芯片晶体管数量达到1530亿,更不用说算力超强的英伟达了。

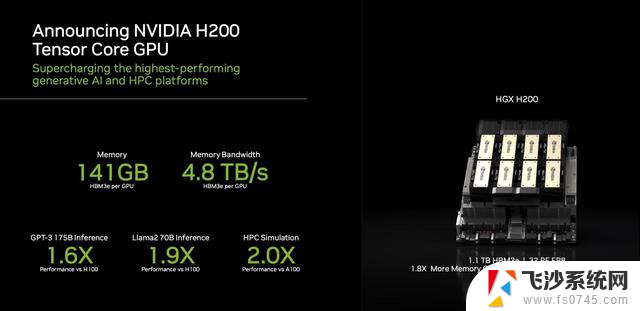

以最近发布的H200为例,GPU核心和H100相同,但CUDA核数达到16896个,加速频率1.83GHz,显存具备更大的容量和更高带宽,可以支持超大参数的大模型训练与推理。官方给出的参数显示,H200相较上一代产品在Llama2和ChatGPT的训练速度分别能提升40%和60%。

可以看出,从MI 300X到H200,再到Maia 100,大厂对训练参数量、训练速度和芯片算力的追求是没有上限的。大模型的迭代速度也在加快,只因各家大厂都想跑得比对手更快一步。

芯片是这场算力竞赛里最关键的一环,没有人想在这上面掉链子。而为了摆脱对英伟达的依赖,自研就是最好的出路。

当自研AI芯片成为必选项

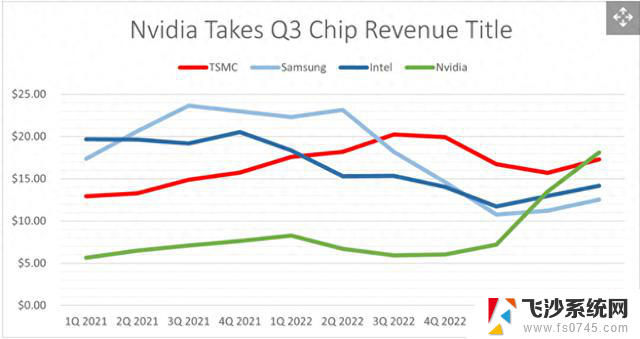

英伟达的芯片不是不好,反倒是太好了,好到直接滋生了两个难以解决的问题:一是供不应求,二是价格高不可攀。

英伟达没有正面回应H100和A100两款最热门产品的产能和需求,但今年内H100加速卡的产能至少同比增长了3倍,且仍有许多产能瓶颈无法解决。比如台积电5nm生产线产能,英伟达的GPU必须使用台积电的CoWoS封装技术,市面上完全找不到别的替代品。

供不应求,市场杠杆就会自动生效,调高价格、筛选客户。从去年下半年开始,抢购GPU就成为硅谷大厂最重要的任务之一。大厂为了抢时间、保供应,囤的货一个比一个多,阶段产能愈发吃紧,继而再次推高价格,形成一个死循环。

微软在2019年投资openAI后算过一笔账,为了支撑历代ChatGPT的训练,微软每年光是采购A100的资金就在数亿美元以上。而稍晚启动的自研芯片计划,每年开销只需1亿美元左右。白纸黑字摆在面前,大厂也不傻。本就有一定技术,也有足够流动资金的微软、谷歌、亚马逊、Meta们,纷纷加速拥抱自研芯片。

这当中,谷歌和亚马逊是起步最早、成绩也最突出的。单论研发实力,微软甚至够不着硅谷的第一梯队。

得益于在手机领域的长期布局,谷歌积累了大量芯片技术,除了美国本土之外,还在印度设置了大规模的芯片研发中心。2021年推出的自研芯片Tensor使用三星5nm先进制程,GPU性能较上一代产品大幅提升370%,狠狠秀了一把肌肉。

这几年,谷歌从高通、苹果、英伟达、博通挖来大量人才。最新消息显示,谷歌计划在2027年将博通剔除出AI芯片供应商的行列,每年将节省数十亿美元的采购费用。而对标博通的TPU,就成为了谷歌AI芯片计划的重点发力方向。

事实上,谷歌的TPU自研计划也是由来已久。2021年,时任谷歌研究部门主管Cliff Young就透露,谷歌有长期的计划,会在数据中心部署大量自研TPU,以加强云端运算速度,未来不排除将对外出售。

亚马逊也是自研芯片的老玩家,其强大在于,建立了完整的自研芯片产业链,形成网络芯片、服务器芯片、AI芯片三条产品线。在AI 芯片领域,亚马逊的自研产品就通用计算芯片、机器学习训练芯片、学习推理芯片等。

满打满算,从2013年推出首款自研芯片Nitro 1以来,亚马逊已经推出了超过10款自研芯片,无论数量还是覆盖的领域,都远超其他硅谷大厂。AWS在2020年便发布了用于训练大模型的自研芯片Trainium,也是最早发力AI专用芯片的大厂之一,为AWS征服全球立下汗马功劳。

就连落后一截的Meta,也在今年高调提出造芯计划,推出定制芯片MTIA v1,并牵手高通、重组研发团队。为了夺回主动权、节省开销,大厂肯定会拼尽全力。接下来,不知道英伟达将如何接招?

取代英伟达谈何容易,在博弈中合作将成为主题

硅谷大厂的反抗之心,黄仁勋当然了然于胸。与其说英伟达对微软、亚马逊、谷歌们的进攻无动于衷,倒不如说是有恃无恐——硅谷大厂的自研芯片算力远不比上英伟达,也缺乏配套的AI软硬件。想自供自给乃至取英伟达而代之,在现阶段并不现实。

算力上的差距前文已有介绍,此处不再赘述。在芯片算力之外,英伟达还强在拥有Base Command(AI训练端到端软件服务)、AI Enterprise(提供平台支持的企业级软件)等大量配套设施。

(图片来自英伟达官网)

微软等大厂自研AI芯片,是为了降低采购成本。但大模型从训练到落地应用,需要的绝不止一颗芯片。当参数级别变得原来越高,开源程度不断提升,需要使用的配套软硬件也会越来越多,这时候大厂们就不得不重新算一下自己的账本了。

高调发布自研芯片的微软,就很清楚自己短时间内离不开英伟达和AMD。纳德拉之所以请黄仁勋到场助阵当然不是为了示威,而是示好。展望未来,大厂之间的暗中角力当然少不了,但合作还是主旋律。

黄仁勋出席微软Ignite全球技术大会,是为了宣传针对英伟达H100设计的NC H100 v5虚拟机,这是一项类似于AI代工的服务,可以帮助Azure的客户和合作企业开发大语言模型。此外,微软Azure仍在使用AMD的 MI300X加速虚拟机和最新的GPU提高AI模型训练和推理速度。

值得一提的是,微软在15日的技术大会上还宣布推出MaaS模型即服务,向用户开放API接口,以便在云端部署自己的开源大模型。Meta等大厂据悉也将加入开源行列,Llama 2等知名大模型都会在英伟达的算力支撑下,陆续向第三方开放调用。

纳德拉和黄仁勋心底盘算什么,外人看不见,也猜不透。但至少在明面上,两人会继续维持良好的合作关系,有钱一起赚。真正感到压力山大的,其实是那些艰难求存的初创企业——毕竟大部分芯片企业都要依赖投资人和大厂的资金搞研发。大厂发力自研后必然会削减外部投资,甚至还会挤压前者的生存空间。

从2020年的Wave Computing开始,这几年时不时有AI芯片独角兽裁员、卖身甚至直接倒闭。不久欧倩,英国GPU芯片公司Imagination也被爆将进行裁员,比例在20%左右。

Wave Computing也算得上红极一时,当初曾声称要追赶英伟达。自家的DPU产品在加速神经网络的训练速度上要超过英伟达的GPU1000倍,基于DataFlow架构设计的产品也算得上特立独行。

不过之后的故事大家都清楚了,Wave Computing的DPU在某些参数上确实超过了英伟达的GPU,但不具备推广意义。因为前者缺乏通用计算架构,也无法针对不同应用场景进行定制化改造,更没有足够数量的开发者。在烧光了投资人的资金后,最终只能走向破产清算的地步。

无独有偶,openAI在日前悄悄更新,也让部分AI初创企业感到“末日将至”,更有外媒表示openAI“正在杀死生成式人工智能初创公司”。由此可以看出,做AI大模型和做AI芯片的公司生存压力巨大,研发难度和高企的经营成本随时都可能将它们压垮。

大公司和初创企业之间的矛盾由来已久,大厂发力自研AI芯片只不过是一剂催化剂。想在巨头的夹缝谋得一丝生存空间,初创企业要拿出更多真本事。