通过世界基础模型生成的合成轨迹数据,优化机器人学习效果

通用机器人的时代已经到来,这得益于机械电子技术和机器人 AI 基础模型的进步。但目前机器人技术的发展仍面临一个关键挑战:机器人需要大量的训练数据来掌握诸如组装和检查之类的技能,而手动演示的方式难以扩展。基于 NVIDIA Cosmos 构建的 NVIDIA Isaac GR00T-Dreams blueprint,可以通过单张图像和语言提示生成海量的合成轨迹数据,能够有效解决这一难题。

利用 Cosmos 世界基础模型 (WFMs) 和生成式 AI,开发者可以快速创建用于训练诸如 NVIDIA Isaac GR00T N1.5(全球首个面向人形机器人推理和技能的开源基础模型)等模型的数据。

本文将介绍 Isaac GR00T-Dreams blueprint,详述其先进功能及其在开发 Isaac GR00T N1.5 基础模型中的作用。

GR00T-Dreams blueprint 概览

Isaac GR00T-Dreams blueprint 是用于生成大量合成轨迹数据的参考工作流,生成的数据可以用于教会人形机器人在新环境中执行新动作。

借助这一蓝图,机器人仅需极少量的人类演示数据,就能够泛化各种行为,并适应新的环境。因此,一个小型人类演示团队就能创造出以往需要数千人才能产出的训练数据量。

GR00T-Dreams blueprint 是对 Isaac GR00T-Mimic blueprint 的补充。通过使用 NVIDIA Omniverse 和 Cosmos Transfer-1 WFM 扩展已知任务的现有演示数据,GR00T-Mimic 可帮助机器人培养深度熟练程度,并成为这些特定技能的专家。GR00T-Dreams 采用 Cosmos Predict-2 和 Cosmos Reason 为新任务和环境生成全新数据,致力于使机器人成为具有广泛适应性的通用机器人。

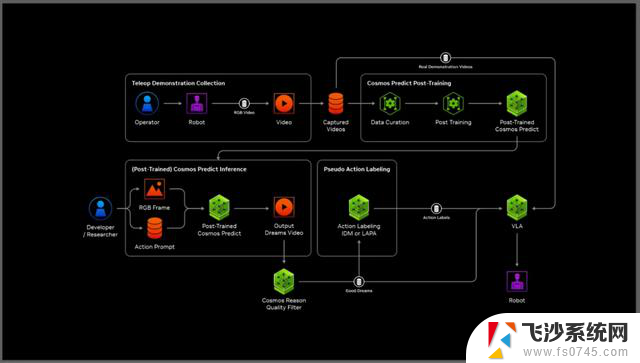

GR00T-Dreams blueprint 工作流

该蓝图为训练通用机器人提供强大的“现实到现实 (real-to-real)”数据工作流,使用真实机器人数据创建合成轨迹,然后用于训练物理机器人。这种方法显著减少了对大量人类演示的需求。具体步骤如下:

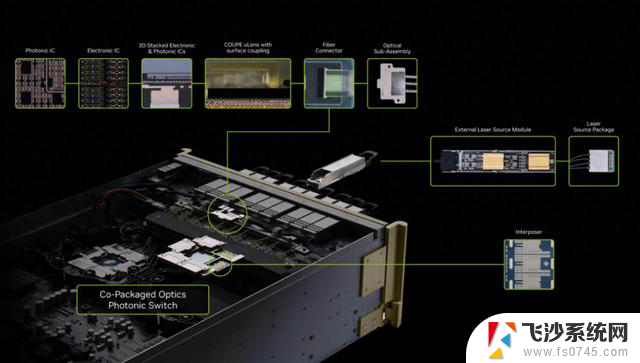

图 1. GR00T-Dreams blueprint 架构

第一步:利用人类演示进行后训练

首先,开发者收集用于人形机器人在单一环境中执行单一任务(如抓取与放置)的一组有限的人类远程操作轨迹。然后利用这些真实世界数据对 Cosmos Predict-2 世界基础模型进行后训练。这一步骤可让模型学习该机器人特有的特定移动能力和功能约束。

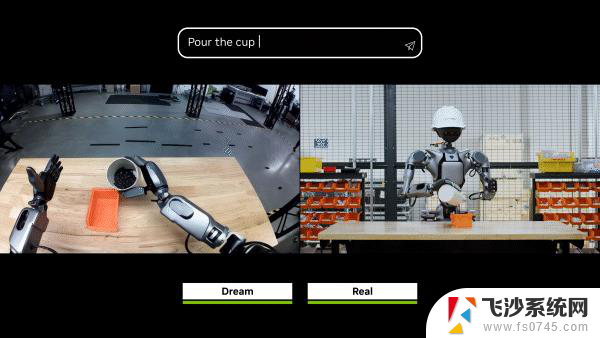

第二步:生成“梦境”

接下来,开发者向经过微调的 Cosmos 模型输入初始图像和基于文本的新指令,要求生成的机器人执行相应动作。这会促使生成式模型创建大量多样化和新颖的任务场景或未来世界状态(也称为“梦境”),例如打开、关闭、整理物体、清洁和分类等。这些场景以 2D 视频的形式创建。

第三步:推理和过滤

生成大量“梦境”后,Cosmos Reason 模型可用于评估每个“梦境”的质量和成功率。它会过滤掉“不好的梦境”,也就是描绘不成功或有缺陷的任务尝试,确保仅让高质量和相关的场景进入下一阶段。

第四步:提取神经轨迹

选中的“梦境”最初只是 2D 视频中的像素,随后利用逆动力学模型 (IDM) 生成 3D 动作轨迹。IDM是用于动作标记的生成式 AI 模型,该模型通过输入 2D 视频中的两个图像帧,即“之前”和“之后”的画面,预测出这两个画面之间发生的一系列动作。

这一步骤将“梦境”视频中的视觉信息转化为机器人能够学习的可操作数据。这些已添加 3D 动作数据的 2D 视频被称为神经轨迹。

第五步:训练视觉运动策略

最后,这些神经轨迹作为大规模的合成数据集,用于训练视觉运动策略,既可以与真实世界数据协同训练以增强性能,也可以仅通过对这些数据进行训练,来实现对新行为和不可见环境的泛化。

用于机器人学习的高级功能

GR00T-Dreams 为机器人学习提供了先进的功能,包括新行为、新环境等。

新行为:即使仅有单一任务(例如抓取与放置)的训练数据,机器人也能从语言指令中学习新动作。

图 2. 由 GR00T-Dreams 支持的机器人打开笔记本电脑的神经轨迹和真实机器人 (Fourier GR-1) 执行情况

新环境:即使世界模型仅在一个实验室环境中训练过,机器人也能够泛化到完全未见过的环境。

图 3. 由 GR00T-Dreams 支持的机器人将橘子放入碗中的神经轨迹和真实机器人 (Fourier GR-1) 执行情况

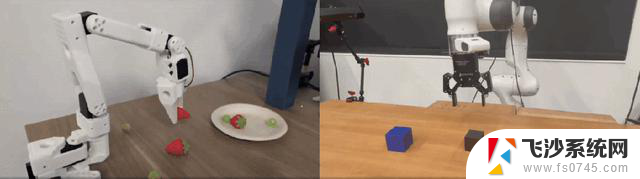

多种机器人类型:适用于从人形机器人到机械臂(如 Franka 和 SO-100)等不同类型的机器人,并支持多种摄像头视图。

图 4. 由 GR00T-Dreams 支持的 Franka 机械臂和 SO-100 机械臂执行不同操作任务

针对复杂任务增强学习:为具有挑战性的接触密集型任务,比如操作可变形物体(折叠)或使用工具(锤击)等增强训练数据。形成从初始真实画面开始的“真实到真实”工作流。

图 5. 由 GR00T-Dreams 支持的机器人锤击操作的神经轨迹和真实机器人 (Fourier GR-1) 执行情况

使用 GR00T-Dreams

对 GR00T N1.5 进行后训练

可以使用 GR00T-Dreams 对视觉语言动作 (VLA) 模型进行后训练,以在未见过的环境中实现新行为和操作。

NVIDIA 研究中心使用 GR00T-Dreams blueprint 生成合成训练数据,仅用 36 小时就完成了 GR00T N1.5 的开发。如果使用人工收集人类数据,这一过程需要近三个月的时间。

GR00T N1.5 是 GR00T N1 的首次更新,GR00T N1 是全球首个面向通用人形机器人推理和技能的开源基础模型。这个跨形态模型可以接收语言和图像等多模态输入,在多样化的环境中执行操作任务。

GR00T N1.5 的新功能:

开源的 NVIDIA 物理 AI 数据集

NVIDIA 扩展了其开源物理AI数据集。该数据集是 Hugging Face 上下载量最多的机器人数据集,最初于 2025 年 3 月推出,如今新增了数千条机器人轨迹,包括 Unitree G1 机器人的首批真实训练数据和 24,000 条仿真远程操作轨迹。

该数据集还包含各种操作任务的合成仿真数据,在开发 GR00T N1.5 的过程中发挥了重要的作用。

GR00T N 模型在机器人生态系统的应用

GR00T N 模型已经被很多生态合作伙伴采用,包括 AeiRobot、Foxlink、光轮智能和 NEURA Robotics 等。

AeiRobot 利用这一模型使其工业机器人能够理解自然语言,从而完成复杂的抓取与放置任务。Foxlink 利用这一模型提高其工业机械臂的灵活性和效率。光轮智能借助这一模型验证合成数据,以加快人形机器人在工厂中的部署。NEURA Robotics 正在评估这一模型,以加速其家用自动化系统的开发。

开始加速机器人学习

Isaac GR00T-Dreams blueprint 是用于生成大量合成轨迹数据的参考工作流,这些数据可用于教会人形机器人在新环境中执行新动作。这一蓝图使机器人仅需极少量的人类演示数据,就能够泛化各种行为,并适应新的环境。

开始使用 GR00T-Dreams:

开始使用 GR00T N1.5: